Das Mooresche Gesetzt und die Realität

Am Anfang war es nur eine Prognose. Der Intel-Mitbegründer Gorden Moore vermutete im Jahr 1965, dass sich die Anzahl der Transistoren auf einem Chip ungefähr alle zwei Jahre verdoppeln wird. Als man später feststellte, dass diese technologische Entwicklung in der Realität tatsächlich zu beobachten war, wurde aus der Prognose das Mooresche Gesetz.

Heute, 40 Jahre später scheint dieses Gesetz immer noch zu gelten, wie das folgende Bild zeigt:

|

Das aber würde einem weiteren "Naturgesetz" widersprechen, der zyklischen Bewegung:

|

An diesem Beispiel der frühen IT-Entwicklung wird deutlich, was unter zyklischer Entwicklung zu verstehen ist: Es scheint ein Naturgesetz zu sein, dass viele Prozesse/Entwicklungen in Form einer Erregungskurve ablaufen, die in der technischen Mechanik als "gedämpfte Schwingung" bezeichnet wird. Ein Prozess wird angestossen, die Erregung/Entwicklung erreicht schnell ein Maximum und klingt dann mehr oder weniger schnell ab und strebt asymptotisch einen Wert zu, der dann konstant bleibt. Mehr dazu unter www.storyal.de ...

Es ist naheliegend, dass auch die Entwicklung des Personal Computers (PC) diesem Gesetz gehorcht und nicht dem Mooreschen Gesetz folgt. Das Moorsche Gesetz beschreibt nur die Anfangsphase dieser speziellen Entwicklung, der Transistor-Chip-Technologie. Die Anzahl der Transistoren und damit die Leistung wird sich nicht unendlich lange alle zwei Jahre verdoppeln. Es hat im Gegenteil den Anschein, als ob in den nächsten Jahren die physikalischen Grenzen und damit auch das Maximum der Chip-Technologie erreicht werden.

Technologische Grenzen

In der Computerzeitschrift CHIP 05/2011 befasst sich ein ausführlicher Artikel mit der Perspektive der PC-Technik: "Die Grenzen der PC-Technik". Auf folgende Grenzen wird dort eingegangen:

Quanteneffekte: Bei Prozessor-Chips auf 11-Nanometer-Basis wird die Dicke des Gateoxids nur noch aus einer Atomlage bestehen. Das heisst, dünner kann die Isolationsschicht zwischen benachbarten Transistoren aus physikalischen Gründen nicht mehr werden. Intel und AMD sind von dieser Grenze nur noch zwei Generationen entfernt. Beide wollen 2013 die ersten 14 nm-Chips anbieten.

Konsequenzen: Die Silizium-Technologie ist wahrscheinlich im Jahr 2016 ausgereizt.

CPU-Takt: Die Wärmeentwicklung und -Abführung ist fast der alleinige Aspekt, der den CPU-Takt begrenzt. Wird die CPU mit flüssigem Stickstoff gekühlt, können Taktraten bis 8 GHz erreicht werden (IBM). Weiter aber kann die Taktrate nicht mehr gesteigert werden.

Konsequenz: CPU-Taktraten von 10 GHz sind nicht erreichbar, die reale Grenze liegt bereits bei 5 GHz.

Festplatten: Auch die Datendichte auf einer Magnetspeicherschicht ist begrenzt. Deshalb kann die Speicherkapazität einer Festplatte (und/oder ihre Miniaturisierung) nicht unbegrenzt erhöht werden. Auch SSD-Speicher (Flashspeicher) lassen sich nicht unbegrenzt vergrössern. Gegenwärtig wird die 25 nm-Generation ausgeliefert. Spätestens bei 11 nm treten die gleichen Isolationsprobleme wie bei den Prozessoren auf. Verschleiss (!) durch Elektronen ist aber schon bei der 25 nm-Generation ein Problem. Deshalb wird vor der 11 nm-Generation die Leistungsgrenze von SSD-Speichern erreicht sein.

Konsequenz: Die maximale Speicherkapazität von 3,5"-Festplatten wird bei 5 TB liegen. SSD-Flash-Speicher sind ungeeignet als ultimatives, digitales Speichermedium.

|

Multitasking:

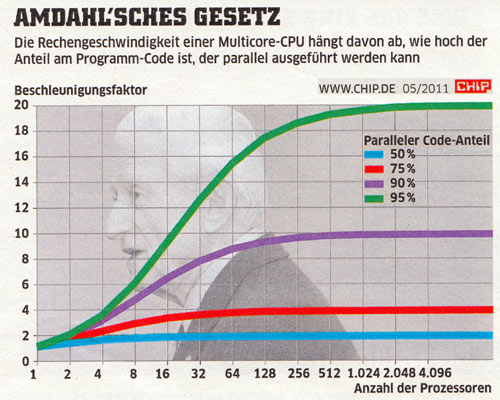

Schon seit dem Jahr 2006 werden, beginnend mit dem Intel Core 2 Duo, Multicore-Prozessoren eingesetzt, um die PC-Leistung deutlich zu erhöhen. Das scheint eine simple und sehr wirkungsvolle Lösung zu sein. Allerdings muss die Software auf das Multitasking ausgerichtet sein. Auch wenn das der Fall ist, kommt das Amdahl'sche Gesetz ins Spiel: Die Anzahl der zusammengeschalteten Prozessoren steigert die Leistung nicht linear, sondern auch hier werden Grenzen erreicht, wie das untere Bild zeigt.

Konsequenz: Der Einsatz vieler Prozessoren erhöht die Systemleistung nicht beliebig.

|

Trotzdem - Kein Ende der PC-Entwicklung

Wenn technologische Grenzen erreicht sind, bedeutet das noch lange nicht das Ende der PC-Entwicklung. Es bedeutet nur, dass die Möglichkeiten der Silizium-Transistor-Technologie ausgeschöpft sind und Leistungssteigerungen nicht mehr in dem Umfang der letzten 40 Jahre möglich sind. Die Maximalleistung ist erreicht, weitere Leistungssteigerungen ohne Technologiewechsel sind, wenn überhaupt, nur mit wesentlich höherem Aufwand als bisher zu erreichen.

Damit gelangt die PC-Entwicklung in den Bereich, in dem die Autos mit Verbrennungsmotor seit mindestens 30 Jahren verharren: Die Leistung (Wirkungsgrad) des Verbrennungsmotors hat auch längst ihr Maximum erreicht. Geringe Leistungssteigerungen sind nur noch mit sehr hohem Aufwand zu erreichen. Das ist der Grund, warum zwar seit 30 Jahren vom Zwei-Liter-Auto geredet wird, aber es nicht existiert. An der Autoindustrie aber ist beispielhaft zu erkennen, dass mit der Erreichung von Leistungsgrenzen absolut nicht der Niedergang einer ganzen Industriesparte verbunden ist.

Und genau das ist auf die PC-Entwicklung zu übertragen:

Leistung

Zuerst stellt sich die Frage, wer überhaupt mehr Leistung benötigt, als heutige PC's besitzen? PC heisst "Personal Computer", es geht also um PC-Leistungen, die am heimischen Schreibtisch benötigt werden, es geht um private Anwendungen! Da ist eindeutig nur eine Nutzergruppe zu erkennen, die nach mehr Leistung giert: Die Gamer. Spiele erfordern heute die grösste Rechenleistung, weil es sich hierbei um interaktive Videos handelt, die erfordern, dass von komplexen, rechnerinternen Modellen 30 Bilder pro Sekunde mit möglichst hoher Auflösung gerendert werden. Weil die Auflösung nicht gross genug sein kann, ist hier auch der Leistungshunger unbegrenzt. Damit aber müssen Gamer einfach zu professionellen Rechnern greifen, wenn der PC mit sechs Prozessoren nicht mehr ausreicht: PC-Cluster machen sehr hohe Rechenleistungen verfügbar, denen aber durch das Amdahl'sche Gesetz auch Grenzen gesetzt sind (s.o.). Heutige Supercomputer bestehen aus solchen Clustern. Im November 2010 hatte z.B. die US-Firma Cray Inc. 224162 Prozessoren zu einem Supercomputer zusammengeschaltet: Rank Nr. 2.

Hardware

Der PC bestehe ja nicht nur aus dem Prozessor. Wichtige periphere Geräte sind Monitor, Drucker, Scanner, Maus und Tastatur. Hier sind keine technologischen Grenzen erkennbar, bzw. es haben bereits Systemwechsel stattgefunden (Beispiel: Röhrenmonitore wurden durch Flachbildschirme abgelöst). Neben dem Prozessor existiert noch sehr viel unvollkommene Hardware - Ein weites Feld für PC-Entwicklungen.

Software

Die Software ist überhaupt nicht von einer Leistungsgrenze der Hardware betroffen. Auf diesem Feld aber ist noch jede Menge Entwicklungsarbeit zu leisten, denn de facto ist der PC ja massenhaft erst seit 25 Jahren verfügbar. Wie sah das Auto im Jahr 1915 aus?! Das ist der heutige Entwicklungsstand der PC-Technik! In einigen Bereichen sind Innovationen dringend erforderlich: Human Interfaces, Datensicherheit und intuitive Bedienung. Auf intelligente Software und Rechner kann man nicht hoffen, denn für künstliche Intelligenz fehlt bisher jeder praktikable Ansatz!

Anwendungen

Die Durchdringung der Computertechnik in der Wirtschaft, der Verwaltung und im öffentlichen sowie privaten Leben ist zwar bereits erstaunlich hoch, aber noch ganz wesentlich zu steigern. In neuen Anwendungen liegt ein riesiges Entwicklungspotential, das nicht von der Leistungsgrenze der PC's abhängig ist.

Systemwechsel

Das zyklische Entwicklungsgesetz zeigt auch, dass jede Technologie oder Technik ein für sie charakteristisches Leistungsmaximum besitzt. Ein Beispiel: Ein Mensch mit zwei Beinen wird nie 100 Km/h laufen können. Die heutige Leistung der PC's wird sich vielleicht noch einmal um den Faktor zwei oder drei steigern lassen, dann aber ist Schluss. Diese Technologie ist damit ausgeschöpft und es kommt das Gesetz vom Umschlag der Quantität in Qualität zur Anwendung: Eine weitere, qualitative Leistungssteigerung erfordert einen Technologiewechsel. Die Zukunftstechnologie steht bereits in den Startlöchern. Der Quantencomputer. Diese prinzipiell neue Leistungsklasse wird für professionelle Simulationen hoch komplexer Prozesse (Wetter, Klima) benötigt. Der Quantencomputer könnte um Grössenordnungen schneller sein, weil er Multitasking in neuer Qualität ermöglichen wird. Das ist für private Anwendungen aber völlig unnötig und damit uninteressant.

Facit

Die Leistungsfähigkeit von Prozessoren auf der Basis von Transistor-Chip-Technologie ist in ein paar Jahren ausgereizt. Der private Rechner wird davon nicht berührt, weil heute schon mehr Leistung angeboten als benötigt wird. Abgesehen von der Systemleistung existieren noch sehr viele ungelöste Entwicklungsprobleme, um die Anwenderfreundlichkeit der PC-Systeme zu verbessern. Für professionelle Anwendungen - in erster Linie komplexe Simulationen und Rendering/Visualisierung virtueller Modelle - wird durchaus mehr Leistung benötigt. Die Digitaltechnik sucht nach Systemen, die prinzipiell anders funktionieren und deshalb andere Leistungsgrenzen besitzen, als die Transistor-Technologie. Ein solches zukunftsträchtiges System ist der Quantencomputer. Interessant ist auch die Frage, wie Rechner aussehen könnten, die auf anderen Prinzipien als die Digital-Technologie basieren!

Links zu PC-Technik

Die Grenzen der PC-Technik www.chip.de ...

Der weite Weg zum Quantencomputer www.dradio.de ...

Amdahlsches Gesetz http://hikwww2.fzk.de ...

Neue Nano-Technologie www.paradisi.de ...

Quantencomputer - Eine Einführung www.quantencomputer.de/

Top 500 der Supercomputer www.top500.org ...

Computer der Zukunft www.g-o.de ...

So sieht die Computer-Zukunft aus www.spiegel.de ...